4 000 посетителей в сутки. Что делалось для продвижения? А также, как увеличил трафик с Гугл на 15% за 2 недели…

Всем привет уважаемые читатели. Сегодня у меня есть небольшой кейс о том, как последние дни на блог приходит свыше 4000 посетителей в сутки. И собственно, ничего особо не делал последний месяц. Просто вышли в индекс старые статьи. Вот и всё.

Бывает так, что статья проиндексируется быстро, и попадает в поиск буквально за 1-3 дня, и уже может приводить первых посетителей. Частота индексации зависит ещё от частоты добавления статей в блог. Как видите, я пишу редко.

Но здесь ещё стоит брать во внимание комментарии, и вопросы читателей, которые задают, и тем самым часть старых статей обновляется, и поднимается в поисковых системах выше. Что приводит к увеличению трафика. Так спустя 1-3 месяца, старые статьи могут ещё выше подняться в рейтинге поисковых систем, и приводить больше посетителей на ваш блог.

Пожалуй лучший рекорд, который удавалась достичь из поиска 26 000 за 3 месяца. В теме моего блога, конечно не так всё просто, потому как запросы не такие жирные как в той же кулинарии.

Там, можно 1 статью написать, и привлекать от 500 человек в сутки. Всё дело в жирных запросах. Их частоты на поиске яндекса. Смотрите мой эфир на эту тему в рассылке! А также, юзайте живой поиск яндекса и вордстат.

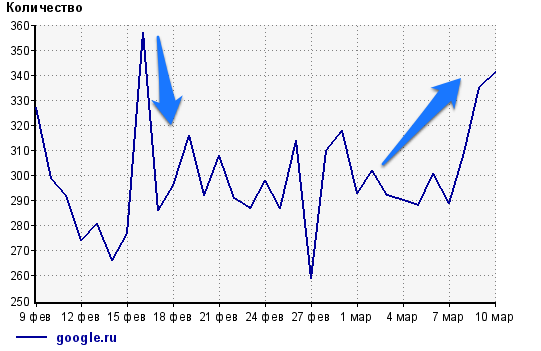

Основное увеличение трафика идет из Яндекса. Но гугл по статистике также дал увеличение посетителей на 15-20%. График в увеличенном виде ниже:

У гугла вообще интересная особенность. Привереда он ещё тот ))

Но ничего! Самое главное, что блогом, вы не зависите от одного источника трафика. А люди приходят комплексно со многих источников. С социальных сетей в том числе.

Вчера с гугла пришло 350 человек. Да это мало ещё, но лучше чем 290. Хотя и не привык копаться в мелочах, но всё же после изменений, всегда приятно смотреть первые результаты труда.

Вообще, мне больше всего нравится, когда люди заходят на блог не с поиска, а именно с закладок. Это самые преданные мои читатели. Большая часть которых подписана на мою рассылку.

У меня на этом всё. Следите за рассылкой!

Ах да.

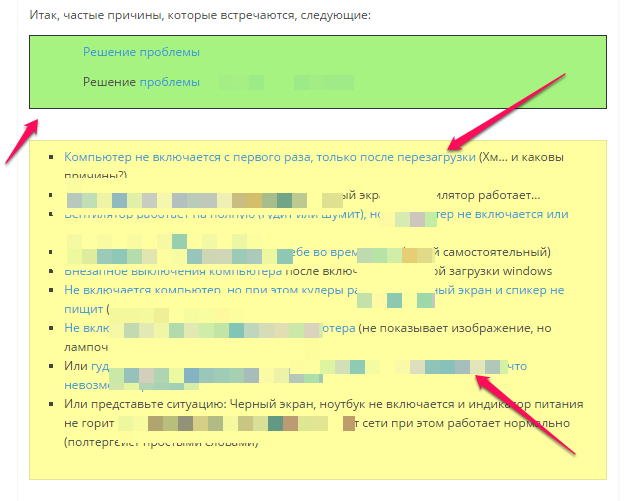

Что сделал, чтобы увеличить трафик с гугл на 15%?

Изменил свой файл роботс, и полностью открыл весь сайт для индексации. Вот как выглядит:

Самое интересное, что ранее был он подобным, но все папки, которые начинались с «wp-» , я запрещал от индекса. Но там были скрипты, которые мешали роботу гугл, правильно индексировать сайт.

Также, гугл ругался на то, что файл роботс составлен с ошибкой. А он на самом деле был правильным.

Но долго не могло дойти, почему же показывал это:

![13[1]](http://leadinlife.info/wp-content/uploads/2016/03/131.jpg)

Что это за такое, ещё?

А оказалось, что мой файл роботс был не в той кодировке. Черт возьми, этот BOM, постоянно вызывает скрытую проблему )) . Подобное было раньше при загрузке медиафайлов на блог вордпресс. Выдавалась ошибка, когда добавлял новую картинку. А оказалось, что часть моих файлов, после переноса на компьютер и обратно, изменили кодировку.

Вот и здесь, нужно было заново открыть файл роботс, и изменить кодировку на «Utf-8 (без BOM)», а индекс для всего сайта открыл специально, чтобы роботу было проще ориентироваться в нем, и загружать все необходимые файлы стилей.

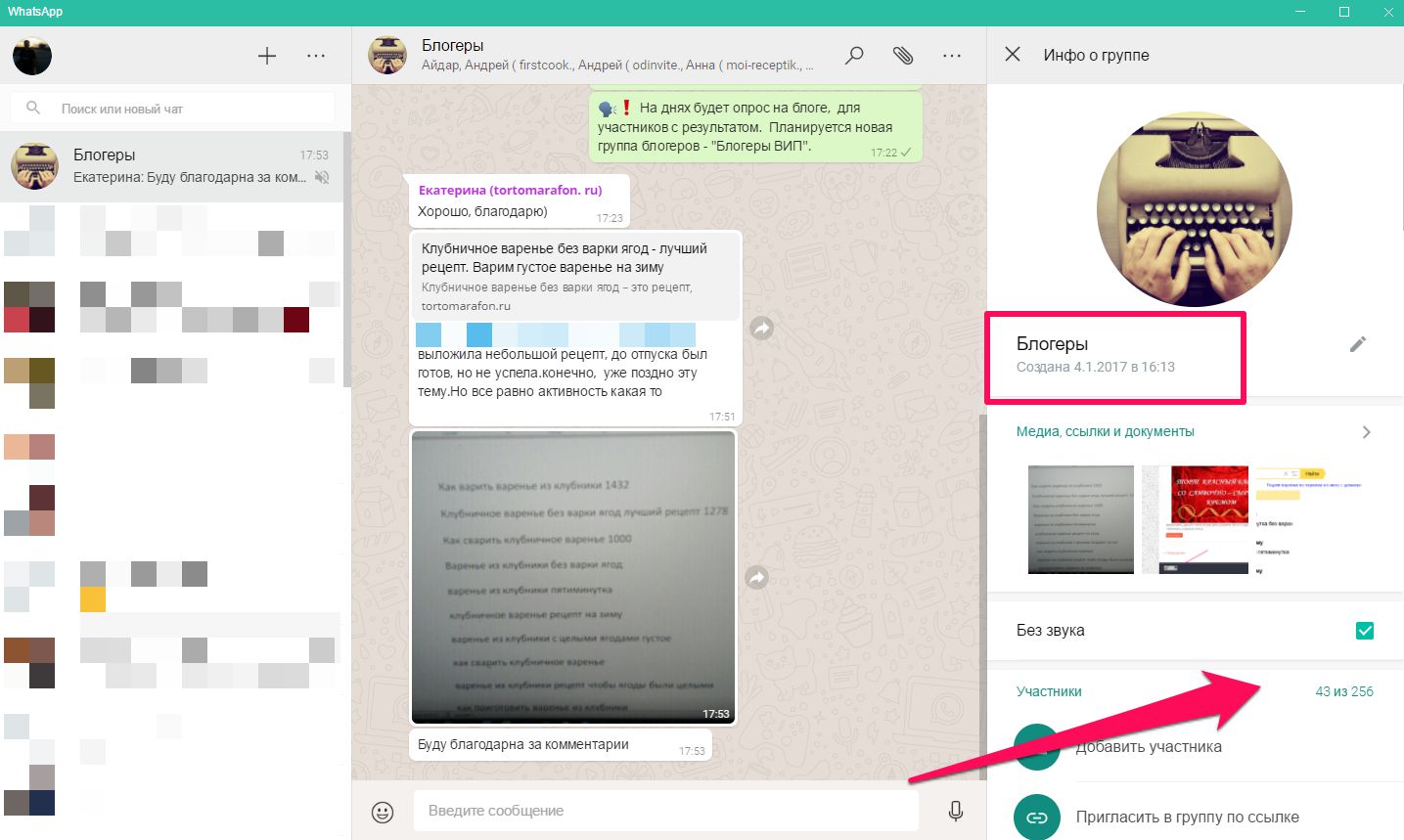

Вот так:

![robo-500x356[1]](http://leadinlife.info/wp-content/uploads/2016/03/robo-500x3561.jpg)

А всё ненужное, нужно исключать не в файле роботс, а непосредственно внутри блога, запрещая индексировать ненужные страницы блога через отдельный мета тег.

Выглядит он так:

Но, подобные изменения должен делать специалист, иначе вставите не там, где нужно, и запретите индексировать весь сайт. Вообще, это те вещи, которые один раз настраиваются и вы про них можете позабыть.

На эту тему, есть полезная информация в рассылке. Всё в видео формате.

Просто следите за изменениями на блоге и читайте письма, чтобы получать актуальную информацию.

Что касается отдельно файла роботс, то мне помогла и эта информативная статья: http://avovkdesign.com/robotstxt-problemy-i-primery-wordpress.html

Также, рекомендую.

На этом, у меня всё!

Я все же оставил Disallow: /wp-admin Так как в этих адресах нету noindex в исходном коде…

И кстати ноиндекс, который прописывает плагин Yoast SEO не канает. Проверял вроде в яндексе, ситуация была такая: у меня проиндексировались страницы вида /page/2

Смотрю исходный код, стоит ноиндекс от плагина, захожу на удалить урл в яндекс вэбмастере, а он мне говорит, что нет оснований для удаления. Прописал через functions.php Ниже в исходном коде страницы появился нормальный ноиндекс, нофоллов. А в плагине ноиндекс, фолллов и он не канает.

Yoast SEO — там всё настраивается. Но дополнительно, нужно прописывать отдельно в файле functions.php

Привет, Денис!

Спасибо за полезные посты.

Такая просьба, мог бы ты написать статейку, как правильно настроить плагин Yoast SEO?

В интернете смотрел, все по разному пишут….

Приветствую, подскажи что за плагин используешь социальных кнопок до и после статьи?

это не плагин. Кнопки от github https://sapegin.github.io/social-likes/ru/

Денис, с robots.txt все понятно, но насчет мета тегов я запутался. Если я правильно понимаю, то их надо прописать в файле function.php в начале?

Также не понятно как должен выглядеть сам код запрещающий индексацию.

Или подскажи пожалуйста, как убрать дубли из поиска?

Они у меня такого вида:

в гугле — page1/2/3 и так далее, но одно хорошо, что название страниц отличаются, т.е. 2-название сайта, 3-название сайта и т.д.

В яндексе же все страницы одинаковые + есть дубли категорий.

Если я правильно понимаю, то можно составить роботс таким образом, чтобы закрыть все страницы и категории для яндекса, а для гугл прописать мета теги?

Денис, спасибо за прошлый ответ. Не стал ставить предложеный плагин, так как на сайте начался бордак из-за него, с категориями да и в микроразметке ошибка вылезла ( так и не исправилась после удаления) Хотел еще спросить, по той же проблеме про дубли пагенации. Пользуюсь All in one seo pack плагином, там есть настройки использовать noindex и nofollow для страниц/записей с пагинацией, т.е. если включить эти функции, то результат будет такойже как и через вашь плагин и дубли страниц page должны вылететь из индекса?

Слышал еще, что страницы page не являются дублями, так как у них разная информация на страницах. Что думаете по этому поводу?

информация разная, а шаблон однотипный, начиная от самой основы — тега тайтл, и заканчивая футером. меняется только контентная часть, которая кстати уже находится в базе данных поисковой системе. Вот и представьте, когда у вас на сайте таких страниц будет 500 штук , и в поиске они будут высвечиваться как страницы вида 2, 3, 4 и т.д. При чем они не затачиваются под поисковые запросы, и это просто лишний груз , который заносите в поиск. Их нужно исключать!

По плагину нужно проверять , что он делает напрямую в коде, чтобы понять какие теги он подключает . Если добавляет мета тег noindex, значит запрещает индексировать страницу. Если совместно с follow, то роботу разрешено гулять по ссылкам расположенным на странице, но индексировать её нельзя. Если noindex, nofollow — то не индексировать, не учитывать ссылки на странице.

Я например использую плагин «вордпресс сео», и вам советую!

А с другой стороны, не важно какой у вас плагин, важно как всё настраивается. Можно всё настроить и без плагинов. Просто важно понять, что и для чего делается. А плагины лишь облегчают настройку. Чтобы не в коде странице делать изменения, а просто кликая кнопки )).

Хотя, в любом случае приходится делать доработку через код страницы. Потому как плагины англоязычные, и не всё в них есть под русский сегмент сайтов.